Die Geschichte der KI ist ein über Jahrtausende gewebter Teppich, der von Mythen, Magie und mechanischer Präzision durchzogen ist. Es ist eine fortlaufende Erzählung, die bis heute spannend ist und deren neuestes Kapitel gerade jetzt mit rasanten Entwicklungen fortgeschrieben wird.

Wir, die GEO Agentur seowerk GmbH, machen unsere Kunden in diesen neu entstehenden KI Systemen sichtbar.

Die Krise der Logik

Die Weichen für dieses Kapitel wurden durch den deutschen Mathematiker David Hilbert gestellt. Er forderte zu Beginn des Jahrhunderts, die Mathematik auf eine widerspruchsfreie, vollständige und entscheidbare Grundlage zu stellen. Das zentrale Rätsel für die spätere KI war das sogenannte Entscheidungsproblem (Entscheidungsproblem).

- Die Frage: Gibt es einen mechanischen Prozess oder einen Algorithmus, der für jede mathematische Aussage entscheiden kann, ob sie wahr oder falsch ist?

Dieses Problem war die moderne, hochformalisierte Version des Leibnizschen Traumes vom Calculus Ratiocinator. Würde man eine solche universelle Prozedur finden, wären alle mathematischen und logischen Probleme lösbar. Die Antwort kam 1936 von einem jungen britischen Mathematiker: Alan Turing (1912 bis 1954).

Die Universelle Turing Maschine

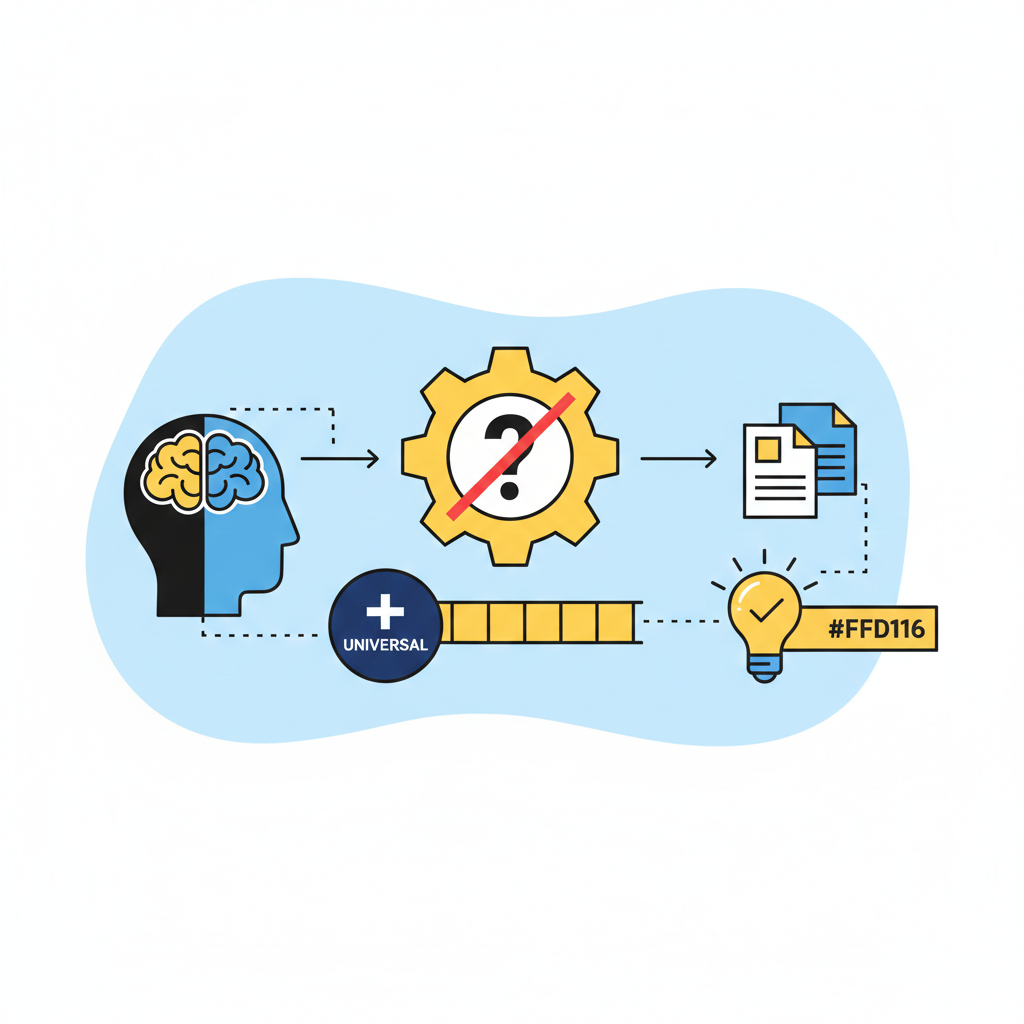

In seiner bahnbrechenden Arbeit On Computable Numbers lieferte Alan Turing die entscheidende Wende. Anstatt nach einem Lösungsalgorithmus zu suchen, definierte er zunächst, was ein Algorithmus überhaupt ist. Er schuf ein Gedankenmodell eines hypothetischen Rechengeräts, die Turing Maschine.

Die Turing Maschine ist minimalistisch einfach. Sie besteht aus einem unendlich langen Band (dem Speicher), das in Zellen unterteilt ist, und einem Lese Schreib Kopf. Der Kopf kann:

- Ein Symbol auf dem Band lesen.

- Ein Symbol löschen oder schreiben.

- Sich nach links oder rechts bewegen.

- Seinen eigenen inneren Zustand wechseln.

Diese primitiven Operationen werden durch eine Reihe von festen Regeln gesteuert. Turing bewies, dass diese einfache Maschine alles berechnen kann, was ein Mensch durch schrittweise Prozeduren berechnen kann. Damit lieferte er die abstrakte Definition des Algorithmus, die heute noch gültig ist.

Die Macht der Universalität

Turings Konzept umfasste eine zweite, noch revolutionärere Idee: die Universelle Turing Maschine (UTM). Er zeigte, dass es eine spezielle Turing Maschine geben kann, die in der Lage ist, die Operationen jeder anderen Turing Maschine zu simulieren. Das heißt, der Algorithmus (das Programm) kann selbst als Daten auf dem Band gespeichert werden.

Dies ist der Urknall der modernen Informatik und der KI. Es bewies, dass es keine prinzipiellen Unterschiede zwischen verschiedenen Rechengeräten geben muss. Ein einziger universeller Computer kann alle berechenbaren Aufgaben lösen, wenn man ihm nur die richtigen Anweisungen gibt. Die Unterscheidung zwischen der Hardware (der Maschine) und der Software (dem Programm) war damit theoretisch geklärt.

Die Grenzen der Vernunft: Das Halteproblem

Die berühmteste Schlussfolgerung von Turings Arbeit war die negative Antwort auf das Entscheidungsproblem. Er bewies, dass es keinen allgemeinen Algorithmus geben kann, der für jede beliebige Turing Maschine und jede Eingabe entscheiden kann, ob diese Maschine jemals anhalten oder für immer weiterlaufen wird (Halteproblem).

Die Implikation war tiefgreifend:

- Es gibt unberechenbare Probleme. Es existieren Aufgaben, die selbst die mächtigste denkbare Maschine nicht durch einen Algorithmus lösen kann.

- Die mechanische Vernunft hat Grenzen. Der Traum von Leibniz, dass jede logische Frage durch reines Rechnen lösbar ist, war formal widerlegt.

Der Weg zur Hardware

Obwohl Turings Arbeit rein theoretisch war, lieferte sie die logische Blaupause für die ersten elektronischen Computer, die kurz darauf im Zweiten Weltkrieg gebaut wurden (z.B. Colossus). Diese frühen Maschinen waren im Grunde physische Realisierungen der Turing Maschine.

Die Turing Maschine ist das konzeptionelle Fundament der KI, weil sie das Spielfeld definierte: Künstliche Intelligenz ist der Versuch, berechenbare Prozesse zu automatisieren. Und sie lieferte die Garantie, dass ein universelles Gerät diese Prozesse ausführen kann. Die abstrakte Natur der Turing Maschine ermöglichte es der Forschung, sich auf die Methode (den Algorithmus) statt auf die spezifische Hardware zu konzentrieren, was den Weg für alle nachfolgenden Entwicklungen ebnete. Ohne die Klärung der Berechenbarkeit hätte die KI Forschung keinen tragfähigen theoretischen Rahmen gehabt.