Welches Potenzial bieten Large Language Model Optimization (LLMO), Generative AI Optimization (GAIO) oder Generative Engine Optimization (GEO)?

Die KI-Revolution wurde am 30.11.2022 durch die Veröffentlichung des populärsten KI-Chatbots „Chat-GPT“ weltweit eingeleitet, welcher auf dem Large Language Model (LLM) GPT des Unternehmens OpenAI basiert. Nach 2 Monaten gab es bereits 100 Millionen Nutzer, im Oktober 2023 zählte die Chat-GPT Website ca. 1,7 Milliarden Besucher. Auch in Deutschland ist das Tool bereits bis in den Mainstream vorgedrungen. Stand November 2023 haben bei einer Befragung von ca. 1000 Teilnehmern 80% angegeben, bereits von Chat-GPT gehört oder gelesen zu haben. 34% der Befragten haben den Chatbot bereits genutzt, 13% nutzen ihn sogar häufig.

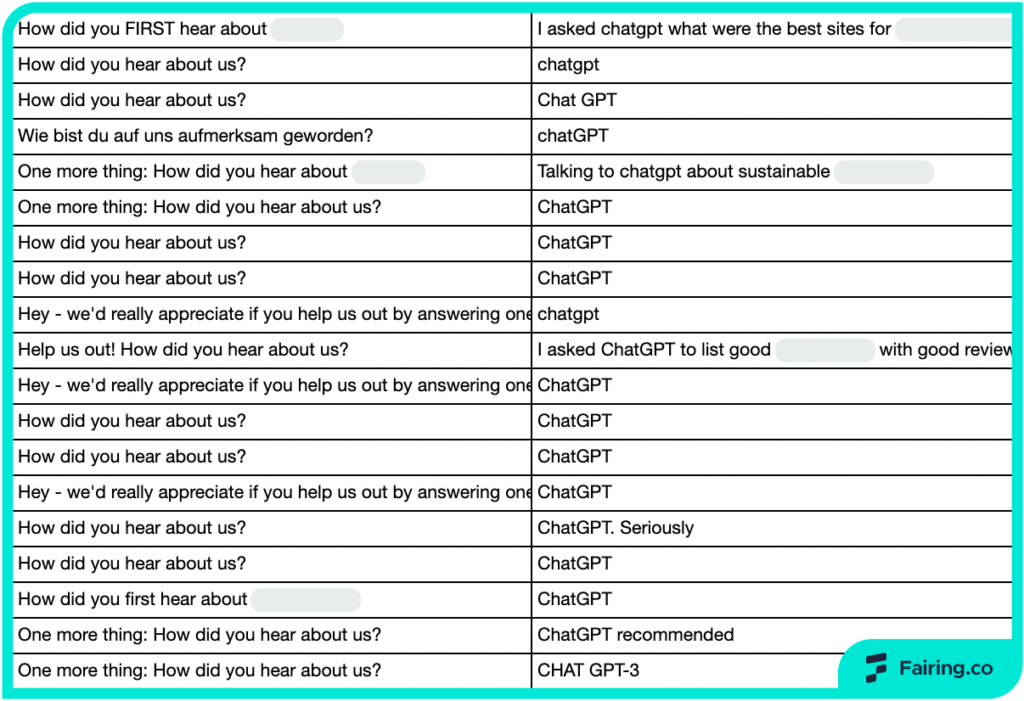

Angesichts dieser Nutzerzahlen kommt bei Marketern & Unternehmen unweigerlich die Frage auf, ob man LLMs & KI-Chatbots gewinnbringend für die eigene Marketingstrategie nutzen kann. Ein erfolgreiches Beispiel dazu gibt es bereits. Das US-Unternehmen „Logikcull“ hat bei einer Umfrage unter Neukunden herausgefunden, dass ein Großteil der Erstkontakte über Chat-GPT zustande gekommen ist. Könnte man einen solchen Effekt replizieren, hätte man einen völlig neuen Kanal zur Kundenakquise gewonnen, welcher von hunderten Millionen potentiellen Kunden genutzt wird.

In der Welt der Suchmaschinenoptimierung gibt es bereits einige Wortschöpfungen, um diesen etwaigen Optimierungsprozess zu beschreiben: Large Language Model Optimization (LLMO), Generative AI Optimization (GAIO) oder Generative Engine Optimization (GEO). Manche Experten beschreiben sogar einen Paradigmenwechsel im Bereich der organischen Optimierung mit dem Begriff "Search Everywhere Optimization" (SEO). Im Folgenden geben wir einen allgemeinen Überblick zu LLMs und KI-Chatbots, deren Auswirkungen auf die bestehende Customer-Journey und erste, theoretische Optimierungsmaßnahmen.

Large Language Models: Definition und Funktionsweise

Large Language Models wie GPT (Generative Pre-trained Transformer) sind generative Sprachmodelle, die mit riesigen Datenmengen (Trainingsdaten) gefüttert wurden. Auf Basis dieser Trainingsdaten ist es LLMs bspw. möglich, Texte zu generieren, Fragen zu beantworten oder Texte zu übersetzen. Dabei ist es wichtig zu verstehen, dass mit „künstlicher Intelligenz“ in diesem Kontext keine wahre künstliche Intelligenz gemeint ist. Vielmehr handelt es sich bei der Architektur und Funktionsweise von LLMs um clevere Statistik: Auf Basis der Trainingsdaten wird den Modellen beigebracht, ob der gelieferte Output korrekt oder inkorrekt war. Sofern das gelieferte Ergebnis inkorrekt war, wird das Tool entsprechend neu kalibriert, bis die Anzahl der fehlerhaften Ergebnisse kaum wahrnehmbar ist. Der Output eines Tools basiert dabei auf Vorhersagen und Wahrscheinlichkeiten: Wort für Wort ermittelt das LLM die wahrscheinlichste Fortsetzung eines Textes.

Mit einem solchen LLM als Grundlage können nun KI-Chatbots erstellt werden. Unter einem KI-Chatbot wie Chat-GPT versteht man Chatbots, die auf LLMs zurückgreifen, um Nutzeranfragen zu verstehen, zu verarbeiten und zu beantworten. Handelsübliche Chatbots würden dabei auf vordefinierte Regeln anstatt ein LLM zurückgreifen, wodurch sie wesentlich beschränkter in ihrer Funktionsweise sind.

KI-Chatbots: Chat-GPT, Bing Chat und Co.

Mit LLMs und den darauf basierten KI-Chatbots hat man also mächtige Tools an der Hand. Anwendungsbereiche gibt es viele, darunter Coding, Texterstellung, Datenmanipulation, aber auch Unterstützung bei ganz alltäglichen Fragen. Weiterhin können bspw. Dateien oder Videos inhaltlich zusammengefasst und Bilder generiert werden. Und wer gerne seinen eigenen, persönlichen Assistent kreieren möchte, kann seinen eigenen GPT bauen und mit Daten füttern.

Diese große Bandbreite erklärt auch die enorme Popularität von Chat-GPT: Das Tool kann sowohl für geschäftliche als auch für private Zwecke verwendet werden. Zum Beispiel kann man sich in einem Chat-Fenster Interpretationen zu einem hochgeladenen Google Ads Reporting liefern lassen, während im nächsten Chat gerade ein Rezept für das Mittagessen generiert wird, welches genau die Zutaten benutzt, die man aktuell im Kühlschrank hat.

Eine der größeren Schwächen von KI-Chatbots ist dabei, dass die Trainingsdaten mit der Zeit veralten. Bei Chat-GPT 4 beispielsweise stammen die Trainingsdaten vom April 2023, was Entwicklungen ab diesem Zeitpunkt für das Tool quasi unsichtbar macht. Es gibt jedoch auch dafür einen Workaround in Form einer Anbindung an den ultimativen, dynamischen Datensatz in Form vom Suchmaschinen-Index. Sofern ein KI-Chatbot in der Lage ist, auf Suchergebnisse, bspw. von Google oder Bing, zuzugreifen, können auch Anfragen bearbeitet werden, welchen top-aktuelle Trainingsdaten zugrunde liegen.

KI-Chatbots und Suchmaschinen

Eine solche Funktion wird zwar schon über Chat-GPT 4 abgedeckt, wo es seit Sommer 2023 ein Feature namens „Browse with Bing“ gibt. Eine wirkliche Symbiose aus KI-Chatbot und Suchmaschinen-Index hat man hiermit allerdings nicht. Diese Rolle nehmen aktuell eher Services wie Bing-Chat, Google Gemini (ehemals Bard) oder You Chat ein.

Neben einem Fix für das Problem der alternden Trainingsdaten versprechen sich Google und Microsoft mit Hilfe dieser Tools weiterhin einen Paradigmenwechsel in der Welt der traditionellen Suchmaschinen. So fortschrittlich wie die heutigen Suchmaschinen-Algorithmen auch sind, ein KI-Chatbot wird früher oder später besser in der Lage sein, die Nutzerintention zu erkennen und zu befriedigen. So ist es für Tools wie Chat-GPT bspw. möglich, wesentlich besser auf komplexe Querys einzugehen und flexiblere Antworten auszuspielen.

Ein Versuch, Suchmaschine und KI-Chatbot miteinander zu verbinden, wird von Google gerade entwickelt. Mithilfe der Search Generative Experience (SGE) soll für einen Großteil der Queries in der normalen Google Suche ein Snapshot auf Basis eines KI-Chatbots ausgespielt werden. Das Tool befindet sich aktuell noch in der Testphase. Laut aktuellem Stand könnte es je nach Nische zukünftig für einen großen Teil der Suchanfragen einen solchen SGE-Snapshot geben. Wie stark sich die traditionelle Suche dadurch ändern wird, hängt wohl von den relevanten Nutzerkennzahlen bei der Interaktion mit dem Tool ab. Fest steht aber: Die KI-Revolution wird sich mit hoher Wahrscheinlichkeit auch auf die großen Suchmaschinen auswirken und die gewohnte Customer Journey ändern. Wann das Rollout von SGE erfolgt, wie das Tool von Nutzern angenommen wird und wie einschneidend sich Klickrate und Nutzerverhalten auf dieser Basis ändern werden, steht allerdings noch in den Sternen.

LLMO, GAIO & GEO: Traffic über KI-Chatbots erhalten

Nachdem nun die aktuelle Situation bzgl. LLMs, KI-Chatbots und deren (möglichen) Auswirkungen auf Suchmaschinen erläutert wurden, bleibt die Frage: Wie kann ich mich als Unternehmen auf diese Änderungen einstellen?

Vorab: Wie auch bei Suchmaschinen gibt es für Large Language Model Optimisation (LLMO) (oder Generative AI Optimization (GAIO) bzw. Generative Engine Optimization (GEO)) keine Schritt-für-Schritt-Anleitung der Hersteller. Eine Ableitung von gewinnbringenden Maßnahmen basiert auf Trial-and-Error, was ein langwieriger Prozess ist. Von daher gibt es aktuell eher theoretische Ansatzpunkte und keine langfristigen Erfahrungswerte mit Ursache & Wirkung. Weiterhin können sich etwaige Maßnahmen und Erträge je nach Branche und Nische massiv unterscheiden.

1. Erzeugen von Kookkurrenzen

Da der Output von KI-Chatbots wie Chat-GPT auf Trainingsdaten basiert, kann eine Nennung der eigenen Marke oder des Produkts nur erfolgen, wenn man in den Trainingsdaten im korrekten Kontext auftaucht. Dabei können mit Trainingsdaten je nach Datenquelle handelsübliche Datensätze oder Suchmaschinen gemeint sein. Als Beispiel dazu: Wenn ein potentieller Kunde bei Chat-GPT nach einer Pfanne für unter 80€ sucht, die zum Braten von Hähnchenfleisch geeignet und leicht zu reinigen ist, muss mein Produkt im Kontext dieser Query in den Trainingsdaten auftauchen. Vorzugsweise in mehreren Quellen. Diese Art der “Streuung” von Inhalten bezeichnet man als “Kookkurrenzen”. Zum Erzeugen von Kookkurrenzen bleiben primär klassische PR-Arbeit und eine langfristige Content-Strategie. Je höher die Markenbekanntheit, Content-Qualität und Content-Quantität, desto höher die Chance, extern referenziert zu werden.

2. EEAT (Expertise, Experience, Authoritativeness, Trustworthiness)

Unter EEAT versteht man eine der relevantesten Richtlinien für Googles menschliche, interne Evaluatoren der Qualität der Suchergebnisse. Quelle und Inhalt sollen in diesem Kontext auf die empfundene Expertise, Erfahrung, Autoritätsempfinden und Vertrauenswürdigkeit geprüft werden. EEAT an sich ist kein direkter Rankingfaktor, sondern eher ein Qualitätsmerkmal von Content und Publishern. Bei der Evaluierung von EEAT können sowohl OffPage-Faktoren, wie die bereits genannten "Kookkurrenzen", als auch OnPage-Faktoren, wie frei zugängliche Informationen zum Publisher (Impressum), herangezogen werden.

Faktoren, die EEAT begünstigen:- Sichtbares Verlinken von Autoren der Inhalte

- Gesamtqualität der Inhalte (Helpful Content)

- Topical Authority zum Thema

- Kookkurrenzen / Zitate von Inhalten auf anderen Portalen

- Aktualität der Inhalte

- etc.

3. Entität-basierte Content Strategie

Der gängige Ansatz in der Suchmaschinenoptimierung, pro Seite ein Keyword abzudecken, wird mit der KI-Revolution nicht mehr ausreichen. Stattdessen sollte der Fokus bei der Content-Strategie auf dem Bespielen von ganzen Entitäten liegen. Im engsten Sinne ist damit gemeint, dass weniger einzelne Begriffe für die Einordnung der Seite vom LLM genutzt werden, sondern wie tiefgreifend eine Seite sich mit der entsprechenden Entität im Kontext des Keywords auseinandersetzt. Hiermit qualifiziert man sich auch für die immer breiter angelegten Queries/Prompts, mit welchen in KI-Chatbots gearbeitet wird. Entsprechend gilt es zukünftig, Inhalte holistischer darzustellen und Entitäten ganzheitlicher zu recherchieren.

4. Allgemeine SEO-Faktoren

Neben den ausgefeilteren Punkten sollten auch die Basics nicht außen vor bleiben. Pagespeed bzw. Core Web Vitals, strukturierte Daten und eine optimierte UX werden auch für KI-Chatbots essenzielle Faktoren bleiben, insbesondere bei solchen, die direkt in Suchmaschinen integriert sind. Besonderes Augenmerk liegt dabei aktuell auf dem Punkt Crawlability, da einige große Publisher sich dazu entschlossen haben, OpenAIs GPT-Bot für das Crawling zu sperren. Hier am Beispiel der robots.txt der New York Times:

User-agent: GPTBot

Disallow: /Sofern Inhalte nicht gecrawlt werden können, ist es natürlich auch nicht möglich, mit Website-Ergebnissen in den Tools aufzutauchen. Je nach Publisher ist es also essenziell, vor anderen Optimierungsstrategien erst abzuklären, ob das Auftauchen in LLMs überhaupt möglich sein soll.

5. Laufende Konkurrenzanalyse

Die Analyse von aktuellen Snapshots in Chat-GPT, Bing-Chat oder SGE (falls via VPN ein Zugriff besteht) sollte in den meisten Fällen recht aufschlussreich sein. Das Rad sollte man dabei nicht neu erfinden und möglichst versuchen, die beeinflussbaren On-Page Faktoren der Konkurrenten ähnlich umzusetzen. Im Optimalfall bemerkt man bei einer solchen Recherche, dass für gewisse Queries ganz andere Anforderungen an die Website gerichtet sind, als man mit dem eigenen Angebot momentan abbildet. In diesem Fall sollte man die eigene Seite bzgl. Inhalt, Suchintention etc. entsprechend anpassen.

Fazit

Zusammengefasst lässt sich sagen, dass das Thema LLMO (GAIO, GEO) hoch spannend ist. Je nach Ausprägung von Features wie Googles SGE könnten KI-Chatbots das Suchverhalten und die Customer Journey von Nutzern nachhaltig verändern. Für Anbieter von Waren und Dienstleistungen ist es daher essenziell, sich so früh wie möglich auf diesen Paradigmenwechsel einzustellen. Erster Schritt dabei wäre natürlich, weiterhin saubere SEO-Arbeit zu betreiben, da das Verhältnis zwischen SEO und LLM-basierten KI-Chatbots wie Chat-GPT und SGE relativ konsistent bleibt.

Inwiefern LLMs und deren Trainingsdaten für umkämpfte Bereiche wirklich beeinflusst werden können, bleibt fraglich. Der Umfang der Trainingsdaten ist teilweise so groß, dass zum Erzeugen von ausreichend Kookkurrenzen hunderte bis tausende externe Nennungen stattfinden müssten, welche dann noch zusätzlich in den Trainingsdaten auftauchen. Für mittelständische Unternehmen wäre dieses Vorhaben realistisch nicht umzusetzen. Je nischiger ein Thema allerdings ist, desto besser stehen die Chancen, auf Basis einer langfristig angelegten Content-Strategie den Weg in KI-generierte Snapshots zu finden.

Quellen

- https://www.techopedia.com/de/30-statistiken-zu-chatgpt-trends-anwendung-und-prognosen

- https://de.statista.com/statistik/daten/studie/1453047/umfrage/bekanntheit-von-ki-einsatz-zur-textgenerierung/

- https://www.bigdata-insider.de/was-ist-ein-large-language-model-a-d735d93bbc24d3c4091de8ce25aa36e8/

- https://www.techopedia.com/de/definition/large-language-model-llm

- https://www.moin.ai/chatbot-lexikon/regelbasierte-chatbots

- https://www.cm.com/de-de/blog/chatgpt-llms-potenzial/

- https://www.analyticaa.com/generative-ai-optimization-gaio-large-language-model-optimization-llmo/

- https://www.derinformatikstudent.de/openai-update-gpt-4-turbo-chatgpt/

- https://blog.google/products/search/generative-ai-search/

- https://peakace.agency/de/latest/sge-rollout-spekulationen/

- https://developers.google.com/search/blog/2022/12/google-raters-guidelines-e-e-a-t?hl=de

- https://www.seokratie.de/google-sge/

- https://www.sem-deutschland.de/seo-glossar/e-a-t-und-ymyl/

- https://www.sem-deutschland.de/blog/llmo-oder-gaio/

- https://www.searchenginejournal.com/googles-gemini-impact-on-seo/506610/

- https://omr.com/de/daily/gaio-llmo-geo-aio-marketing

- https://www.linkedin.com/pulse/ultimate-guide-llmo-geo-aio-malte-landwehr-khqne/